Nöromorfik çip nedir sorusu, özellikle son yıllarda yapay zeka ve makine öğrenimi alanlarındaki gelişmelerle birlikte sıkça gündeme gelen bir konudur. Bu teknoloji, insan beyninin çalışma prensiplerini taklit eden çip sistemleriyle donanım tabanlı yapay zeka çözümleri sunar. Geleneksel işlemcilere kıyasla çok daha az enerji tüketir, daha hızlı karar verir ve özellikle karmaşık verilerle çalışırken büyük avantajlar sağlar.

Nöromorfik Çip Nedir?

Nöromorfik çip, insan beynindeki nöron ve sinaps yapılarını elektronik devrelerle modellemeyi amaçlayan bir mikroçip türüdür. İlk olarak 1980’lerde ortaya atılan bu kavram, günümüzde hem akademik araştırmalarda hem de teknoloji şirketlerinin donanım geliştirme projelerinde aktif olarak kullanılmaktadır. Nöromorfik çipler, klasik Von Neumann mimarisine göre çok daha biyolojik temelli bir hesaplama yöntemi sunar.

Bu çiplerin temel amacı; verileri sadece işlemci ve bellek arasında sürekli taşıyarak değil, veriyi yerinde işleyerek daha verimli hale getirmektir.

Nöromorfik Çiplerin Temel Özellikleri

Nöromorfik çip nedir sorusunu derinlemesine anlamak için bu çiplerin öne çıkan özelliklerini bilmek önemlidir:

-

Düşük enerji tüketimi: Biyolojik sinir sistemine benzer şekilde çalıştığı için minimum enerji ile maksimum performans sağlar.

-

Paralel işlem yeteneği: Aynı anda çok sayıda işlemi yürütebilir, bu da büyük veri uygulamaları için idealdir.

-

Yüksek karar verme kapasitesi: Öğrenme ve adaptasyon yetenekleri sayesinde daha doğru sonuçlar üretir.

-

Donanımsal öğrenme yetisi: Bazı modellerde kendi kendine öğrenme (unsupervised learning) kapasitesi mevcuttur.

Nöromorfik Çipin Geleneksel İşlemcilerden Farkı

Nöromorfik çipler ile geleneksel işlemciler (CPU ve GPU) arasındaki temel fark, veri işleme mimarisi ile ilgilidir.

| Özellik | Geleneksel İşlemciler | Nöromorfik Çipler |

|---|---|---|

| Mimarisi | Von Neumann | Nöron-sinaps temelli |

| Enerji Tüketimi | Yüksek | Düşük |

| Öğrenme Yeteneği | Yazılımsal | Donanımsal |

| Paralel İşlem | Sınırlı | Çok yüksek |

| Uygulama Alanı | Genel amaçlı | Yapay zeka odaklı |

Bu farklar, nöromorfik çiplerin özellikle gerçek zamanlı analiz, nesne tanıma, otonom sistemler ve robotik gibi alanlarda tercih edilmesini sağlar.

Nöromorfik Çipin Uygulama Alanları

Nöromorfik çip nedir sorusu yalnızca teknik bir detay değil, aynı zamanda bu teknolojinin hangi alanlarda devrim yaratabileceğini de kapsar.

Başlıca kullanım alanları:

-

Otonom araç sistemleri: Gerçek zamanlı karar verme kabiliyetiyle öne çıkar.

-

Robotik sistemler: İnsan benzeri tepkiler oluşturabilir.

-

Tıbbi teşhis sistemleri: Görüntü tanıma ve sınıflandırmada yüksek doğruluk sağlar.

-

Ses ve görüntü işleme: Düşük gecikmeli sinyal işleme ile kaliteli sonuç verir.

-

Yapay zeka çipleri: Daha hızlı ve verimli öğrenme algoritmalarını destekler.

Nöromorfik Çipin Avantajları ve Dezavantajları

Avantajları:

-

Enerji verimliliği

-

Hızlı adaptasyon

-

Biyolojik sistemleri taklit edebilme

-

Gerçek zamanlı veri işleme

Dezavantajları:

-

Karmaşık tasarım süreçleri

-

Üretim maliyetlerinin yüksek olması

-

Standartlaşmanın eksikliği

-

Yazılım desteğinin sınırlı olması

Bu dezavantajlar, nöromorfik çiplerin yaygınlaşmasını bir miktar geciktirse de teknoloji ilerledikçe bu sorunların büyük ölçüde çözüleceği öngörülüyor.

Nöromorfik Çip Geleceği Nasıl Şekillendirecek

Nöromorfik çip nedir sorusunun yanıtı, teknolojinin geleceğine dair önemli ipuçları barındırır. Bilgisayar sistemleri daha fazla yapay zeka tabanlı hale geldikçe, nöromorfik mimari donanımların standardı haline gelebilir. Özellikle enerji tasarrufu ve gerçek zamanlı işlem gerektiren alanlarda büyük bir dönüşüm beklenmektedir.

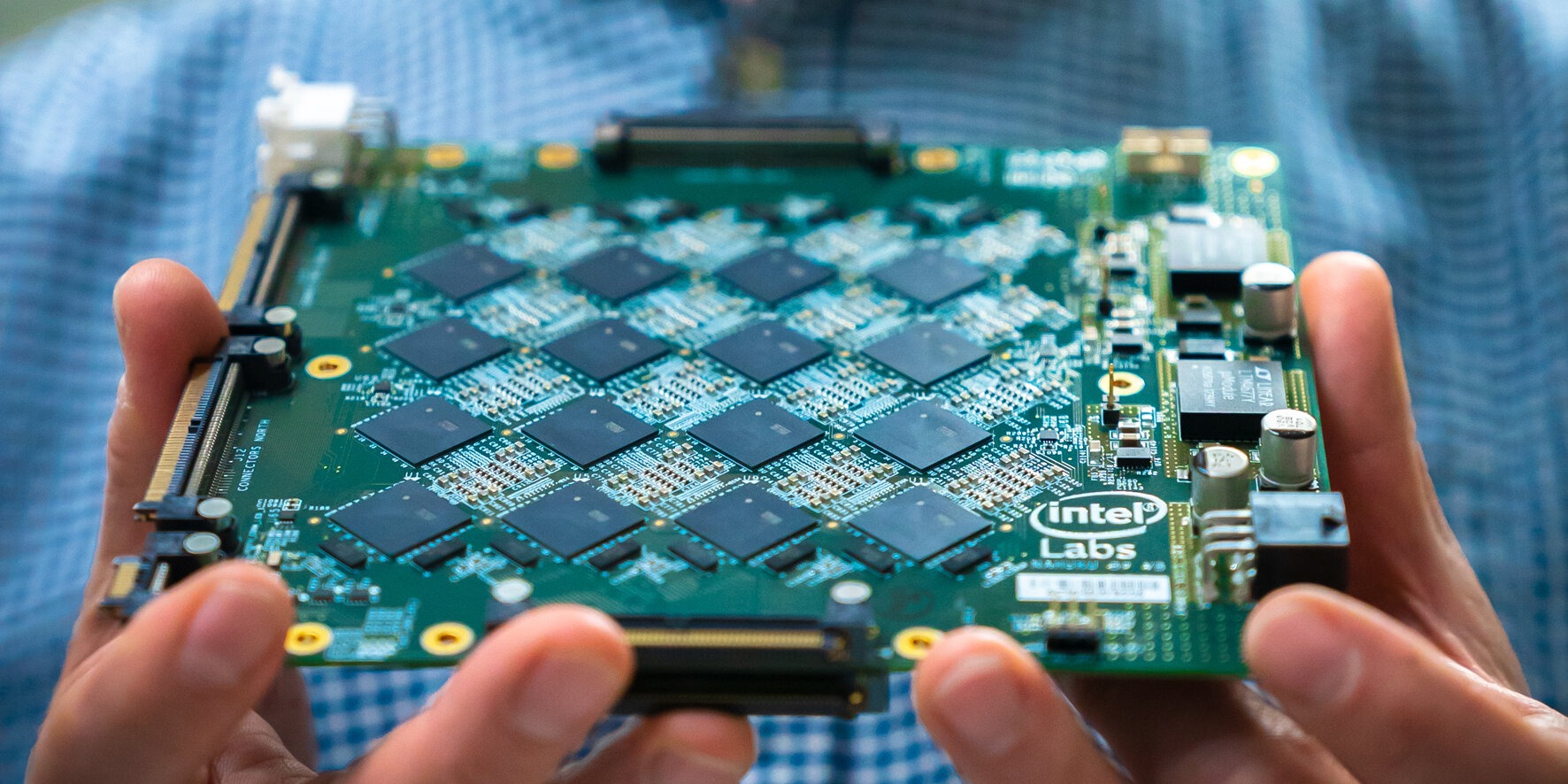

Intel’in Loihi gibi çipleri, bu alanda atılan somut adımları temsil etmektedir. Google, IBM ve BrainChip gibi şirketler de nöromorfik teknolojiler üzerinde aktif olarak çalışmaktadır.

Nöromorfik çip nedir sorusu, teknoloji dünyasının geleceğiyle yakından ilgilidir. İnsan beyninin eşsiz yapısından ilham alan bu çipler, yapay zeka uygulamalarını çok daha hızlı, verimli ve öğrenebilir hale getiriyor. Şu an için gelişmekte olan bir teknoloji olsa da önümüzdeki yıllarda bilgisayar mimarilerinin temelini oluşturacağı öngörülüyor.